Bienvenue

dans notre Kabane

Tous les jours, on se consacre à bâtir le meilleur modèle de relation client-agence au pays.

RIEN DE MOINS.

Familiprix

Projet 2022

Trends 2023 : votre boule de cristal des réseaux sociaux

17/1/2023

Anne-Sophie

Directrice de comptes

Shaker

Projet 2022

Facebook Business Manager 101

5/7/2022

Mélanie

Lead Talent & Culture

Une question d’équilibre.

Et de fit.

Travailler chez nous, c’est choisir un parfait équilibre entre le travail d'équipe et les retrouvailles du soir. Nos talents, on aime les garder longtemps longtemps.

Carrières

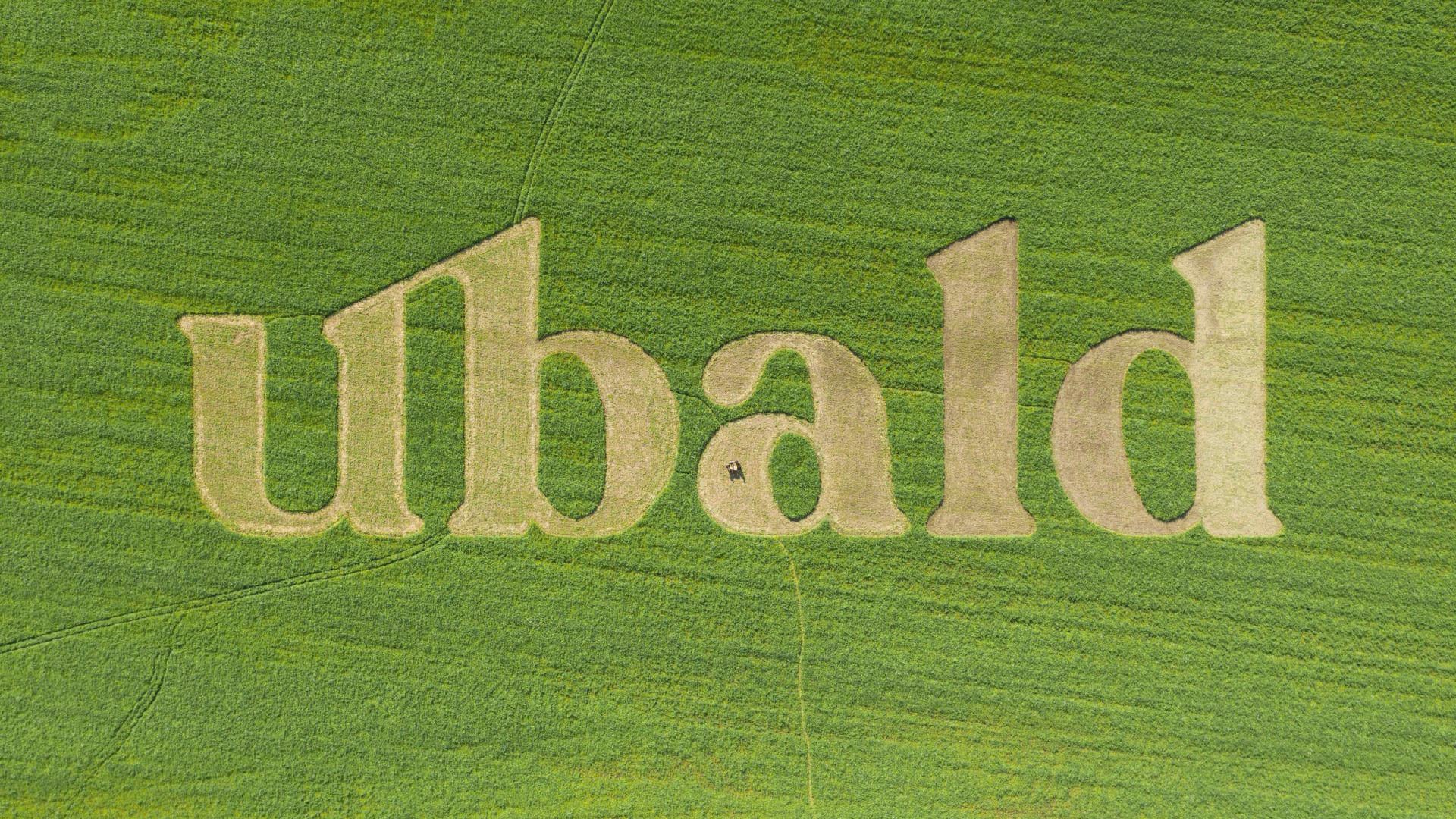

UBALD

Projet 2022

Simon

PrésidentDes expertises tout le tour de la tête.

Avec des talents aussi diversifiés que les nôtres, on s’assure de couvrir tous les angles de nos mandats. Les tout petits comme les plus grands.

Services

Lobe

Projet 2022

Johanna

Designer graphiqueUne agence

tissée ben serré.

Tout ce qu’on fait, on le fait en équipe avec nos client.es. Parce qu’une collaboration saine génère des projets wow (et l’fun).

Agence

Mathieu

Concepteur-rédacteurDes projets qui visent juste.

On a le souci d’être pertinents et percutants, tout le temps. Comme ça, la seule chose qui passe dans le beurre, c’est nos toasts le matin.

Projets

Motion design 101

12/7/2022

Kaleido

Projet 2022